Dùng loại chip 'nhà làm' ra mắt từ 2016, hiệu năng siêu máy tính Google vượt mặt hệ thống của NVIDIA mặc cho đối thủ đang dẫn đầu thị trường chip AI

07/04/2023 18:32 GMT+7 | HighTech

Mặc dù không chiếm nhiều thị phần như NVIDIA trong lĩnh vực chip xử lý phục vụ cho việc nghiên cứu AI, Google thực chất đã sở hữu từ lâu cho mình dòng chip xử lý AI riêng với hiệu năng vượt trội so với hệ thống của đối thủ.

Google mới đây đã công bố thông tin chi tiết về một trong những siêu máy tính được phục vụ cho mục đích phát triển AI của hãng này. Điểm đáng chú ý nhất của siêu máy tính này đến từ việc Google khẳng định nó có tốc độ xử lý nhanh hơn, hiệu quả hơn so với các hệ thống tương tự của NVIDIA.

Đây được coi là một tuyên bố có phần gây bất ngờ, trong bối cảnh NVIDIA vẫn đang chiếm lĩnh tới hơn 90% thị phần thị trường bộ xử lý có thể được sử dụng cho máy học với dòng sản phẩm NVIDIA A100, vốn có giá lên tới 10000 USD/chip. Hóa ra, bản thân Google đã sở hữu riêng cho mình một 'vũ khí tối mật', khi thiết kế và triển khai thế hệ chip xử lý AI có tên gọi Tensor Processing Units, hoặc TPUs, với thế hệ đầu tiên ra mắt từ 2016 và liên tục được cải tiến cho đến nay.

Từ lâu nay, Google luôn là cái tên đi tiên phong trong lĩnh vực AI. Các nhân viên của Google đã phát triển một số tiến bộ quan trọng nhất trong lĩnh vực này trong thập kỷ qua. Tuy nhiên, nhiều chuyên gia tin rằng, trong suốt một thời gian dài, Google dường như đã bị tụt hậu trong việc thương mại hóa các phát minh của mình.

Mãi đến thời điểm các sản phẩm từ đối thủ cạnh tranh như ChatGPT của OpenAI 'làm mưa làm gió', Google mới vội vã chạy đua để tung ra các sản phẩm AI nhằm chứng minh rằng hãng công nghệ này vẫn chưa mất đi vị thế dẫn đầu.

Mặc dù khá im hơi lặng tiếng trước NVIDIA trong lĩnh vực chip xử lý phục vụ cho việc nghiên cứu AI, Google thực chất đã sở hữu từ lâu cho mình dòng chip TPU với hiệu năng vượt trội so với hệ thống của đối thủ. Trong ảnh: Hệ thống Data Center sử dụng chip TPU của Google (Ảnh: Google)

Để giúp sức cho quá trình phát triển AI, hãng công nghệ này tiết lộ đã xây dựng một hệ thống với hơn 4.000 chip TPU thế hệ thứ 4 (ra mắt từ 2021), kết hợp với các linh kiện phần cứng tùy chỉnh được thiết kế để chạy và huấn luyện các mô hình trí tuệ nhân tạo. Siêu máy tính này đã chạy từ năm 2020, và được sử dụng để đào tạo mô hình PaLM của Google, vốn đang cạnh tranh với mô hình GPT của OpenAI.

Các nhà nghiên cứu của Google đã gọi siêu máy tính dựa trên TPU của Google, được gọi là TPU v4, vốn "nhanh hơn 1,2 lần–1,7 lần và sử dụng ít năng lượng hơn 1,3–1,9 lần so với NVIDIA A100".

"Hiệu suất, khả năng mở rộng và tính khả dụng khiến siêu máy tính TPU v4 trở thành chủ lực của các mô hình ngôn ngữ lớn", các nhà nghiên cứu tại Google giới thiệu.

Mặc dù có hiệu năng xử lý và độ hiệu quả tốt hơn đáng kể so với các hệ thống trang bị con chip A100 của NVIDIA, tuy nhiên, sức mạnh và lợi thế của TPU v4 sẽ khó có thể duy trì trong thời gian tới. Theo đó, TPU v4 sẽ không thể sánh được trước H100 – con chip AI mới nhất của NVIDIA, vốn mới hơn và được sản xuất bằng công nghệ tiên tiến hơn, theo thừa nhận của các nhà nghiên cứu Google.

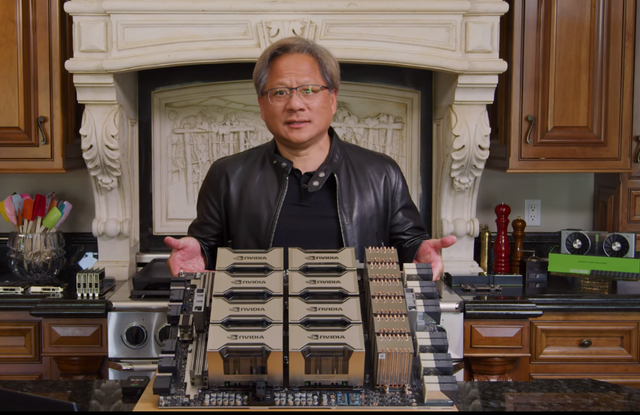

Kết quả và xếp hạng từ bài kiểm tra chip AI toàn ngành có tên MLperf được công bố mới đây, và Giám đốc điều hành NVIDIA Jensen Huang khẳng định con chip H100 nhanh hơn đáng kể so với thế hệ trước.

"Kết quả của MLPerf 3.0 hôm nay đã chứng tỏ sức mạnh của H100, với hiệu suất cao gấp 4 lần so với A100", ông Huang cho biết.

"Cấp độ tiếp theo của AI sáng tạo yêu cầu cơ sở hạ tầng AI mới để đào tạo các Mô hình ngôn ngữ lớn với độ hiệu quả cao về năng lượng", CEO NVIDIA khẳng định.

CEO NVIDIA Jensen Huang giới thiệu các mẫu chip xử lý AI A100 có giá bán lên tới 10000 USD/thiết bị. Đây là con chip đang được sử dụng rộng rãi bởi nhiều công ty trong lĩnh vực trí tuệ nhân tạo, qua đó giúp NVIDIA nắm tới 90%+ thị phần trong thị trường thiết bị phục vụ nghiên cứu AI. Ảnh: NVIDIA

Các mô hình và sản phẩm AI như Bard của Google hay ChatGPT của OpenAI — được cung cấp bởi chip A100 của NVIDIA— yêu cầu rất nhiều tài nguyên máy tính, cùng hàng trăm hoặc hàng nghìn con chip hoạt động cùng nhau trong nhiều tuần hoặc nhiều tháng để đào tạo các mô hình AI.

Theo đó, các con chip AI có thể thực hiện đồng thời nhiều phép tính đơn giản, điều này rất quan trọng đối với việc đào tạo và sử dụng các mô hình mạng thần kinh. Song song đó, các con chip cần phải đủ mạnh để xử lý hàng terabyte dữ liệu một cách nhanh chóng nhằm nhận dạng các mẫu. Cuối cùng, các con chip AI cũng đóng vai trò quan trọng để "suy luận" hoặc sử dụng mô hình để tạo văn bản, đưa ra dự đoán hoặc xác định đối tượng bên trong ảnh.

Đáng nói, các hệ thống siêu máy tính trong lĩnh vực AI như trên thường ngốn một lượng điện năng khổng lồ, dẫn tới các hãng công nghệ phải bỏ ra một chi phí không nhỏ cho…tiền điện

Điều này vô hình trung đã đẩy cao nhu cầu phát triển các con chip AI thế hệ mới, với các thành phần như kết nối quang học hoặc các kỹ thuật phần mềm giúp giảm lượng điện năng tiêu thụ.

Các yêu cầu về năng lượng của AI cũng mở ra cơ hội kinh doanh cho các nhà cung cấp dịch vụ điện toán đám mây như Google, Microsoft và Amazon. Các hãng này có thể cho thuê xử lý máy tính xử lý theo giờ, hoặc cung cấp tín dụng hoặc thời gian tính toán cho các công ty khởi nghiệp để xây dựng mối quan hệ.

Tham khảo CNBC

-

19/04/2024 21:10 0

19/04/2024 21:10 0 -

-

19/04/2024 20:40 0

19/04/2024 20:40 0 -

19/04/2024 20:39 0

19/04/2024 20:39 0 -

19/04/2024 20:32 0

19/04/2024 20:32 0 -

-

-

19/04/2024 18:53 0

19/04/2024 18:53 0 -

19/04/2024 18:49 0

19/04/2024 18:49 0 -

-

19/04/2024 18:00 0

19/04/2024 18:00 0 -

-

19/04/2024 18:00 0

19/04/2024 18:00 0 -

-

19/04/2024 18:00 0

19/04/2024 18:00 0 -

19/04/2024 18:00 0

19/04/2024 18:00 0 -

-

-

19/04/2024 17:45 0

19/04/2024 17:45 0 -

- Xem thêm ›